Imagen: tpacific. Fuente: Everystockphoto

El detective más famoso de la literatura, Sherlock Holmes, sobresalía por su inteligencia, por su capacidad de observación y de deducción, suficiente como para terminar las frases de su querido compañero Watson antes de que el buen doctor tuviera la oportunidad de hacerlo.

Pero, ¿podrían los ordenadores actuar con la misma astucia de Holmes y deducir lo que se va a decir antes de hacerlo?

Un equipo de científicos de la computación de Microsoft Research (MSR), división de la multinacional informática dedicada a la investigación de la ciencia de equipo, en Redmond, junto a compañeros de la Universidad de Cornell y la Universidad de California en Irvine (UCI), ambas en Estados Unidos, están tratando de averiguarlo con interesantes resultados, según publica la web V3.co.uk.

Los investigadores tenían curiosidad por estudiar la capacidad que se presupone a los ordenadores para entender la complejidad semántica del lenguaje. Para ello idearon una serie de algoritmos de aprendizaje automático, con el objetivo de que pudieran analizar y comprender los enunciados que se les presentaran.

Después se dedicaron a ponerlos a prueba con las más variopintas fuentes de datos, desde los más complejos exámenes a populares artículos periodísticos o publicados en la red. Según la procedencia de los datos, los resultados variaron y, con ello, el nivel de éxito del método.

Pero, ¿podrían los ordenadores actuar con la misma astucia de Holmes y deducir lo que se va a decir antes de hacerlo?

Un equipo de científicos de la computación de Microsoft Research (MSR), división de la multinacional informática dedicada a la investigación de la ciencia de equipo, en Redmond, junto a compañeros de la Universidad de Cornell y la Universidad de California en Irvine (UCI), ambas en Estados Unidos, están tratando de averiguarlo con interesantes resultados, según publica la web V3.co.uk.

Los investigadores tenían curiosidad por estudiar la capacidad que se presupone a los ordenadores para entender la complejidad semántica del lenguaje. Para ello idearon una serie de algoritmos de aprendizaje automático, con el objetivo de que pudieran analizar y comprender los enunciados que se les presentaran.

Después se dedicaron a ponerlos a prueba con las más variopintas fuentes de datos, desde los más complejos exámenes a populares artículos periodísticos o publicados en la red. Según la procedencia de los datos, los resultados variaron y, con ello, el nivel de éxito del método.

Coherencia semántica

Como explican los investigadores en su artículo de presentación, en este trabajo se pone a prueba la capacidad de los algoritmos para distinguir el sentido del sinsentido en una frase.

Para ello, se aborda el problema con dos enfoques: métodos que utilizan puramente información léxica, como los n-gramas de un modelo de lenguaje clásico -aquellos que permiten hacer una predicción estadística del próximo elemento de la secuencia- y métodos que evalúan la coherencia global, que necesitan un análisis semántico.

Para cada enfoque, los algoritmos se entrenaron con diferentes test de comprensión, incluyendo preguntas de exámenes propias de Secundaria y pruebas basadas en pasajes de las cinco novelas de Sherlock Holmes escritas por Sir Arthur Conan Doyle.

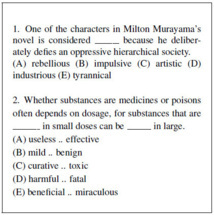

Sobresale la Prueba de Aptitud Académica (SAT, por sus siglas en inglés), basada en frases con uno o dos espacios en blanco para rellenar, con cinco palabras como opción para cada caso. Sólo una de ellas no guarda coherencia semántica.

Estas pruebas están muy limitadas, en el sentido de que toda la información necesaria está presente en la propia sentencia. "Son cuestiones interesantes porque sondean la capacidad de distinguir entre oraciones semánticamente coherentes de las incoherentes, y sin necesidad de más contexto que la propia frase", señalan los investigadores. Sin embargo, varían en dificultad. En general, las preguntas requieren una combinación de conocimiento general y semántico, así como un ocasional razonamiento lógico.

Los algoritmos utilizan la técnica estadística conocida como estimación de frecuencia Good-Turing, basada en los trabajos del precursor de la informática moderna, el británico Alan Turing, durante su colaboración en la Segunda Guerra Mundial para descifrar los mensajes cifrados alemanes.

Tras entrenar a los algoritmos con un amplio corpus de palabras, estos son capaces de predecir la probabilidad de que una de las opciones tenga mayor sentido para rellenar el espacio en blanco. Para ello previamente deben calcular la probabilidad de sentido de la frase con cada una de las opciones posibles.

Como explican los investigadores en su artículo de presentación, en este trabajo se pone a prueba la capacidad de los algoritmos para distinguir el sentido del sinsentido en una frase.

Para ello, se aborda el problema con dos enfoques: métodos que utilizan puramente información léxica, como los n-gramas de un modelo de lenguaje clásico -aquellos que permiten hacer una predicción estadística del próximo elemento de la secuencia- y métodos que evalúan la coherencia global, que necesitan un análisis semántico.

Para cada enfoque, los algoritmos se entrenaron con diferentes test de comprensión, incluyendo preguntas de exámenes propias de Secundaria y pruebas basadas en pasajes de las cinco novelas de Sherlock Holmes escritas por Sir Arthur Conan Doyle.

Sobresale la Prueba de Aptitud Académica (SAT, por sus siglas en inglés), basada en frases con uno o dos espacios en blanco para rellenar, con cinco palabras como opción para cada caso. Sólo una de ellas no guarda coherencia semántica.

Estas pruebas están muy limitadas, en el sentido de que toda la información necesaria está presente en la propia sentencia. "Son cuestiones interesantes porque sondean la capacidad de distinguir entre oraciones semánticamente coherentes de las incoherentes, y sin necesidad de más contexto que la propia frase", señalan los investigadores. Sin embargo, varían en dificultad. En general, las preguntas requieren una combinación de conocimiento general y semántico, así como un ocasional razonamiento lógico.

Los algoritmos utilizan la técnica estadística conocida como estimación de frecuencia Good-Turing, basada en los trabajos del precursor de la informática moderna, el británico Alan Turing, durante su colaboración en la Segunda Guerra Mundial para descifrar los mensajes cifrados alemanes.

Tras entrenar a los algoritmos con un amplio corpus de palabras, estos son capaces de predecir la probabilidad de que una de las opciones tenga mayor sentido para rellenar el espacio en blanco. Para ello previamente deben calcular la probabilidad de sentido de la frase con cada una de las opciones posibles.

Ejemplos de casos del SAT para completar oraciones. Fuente: MSR.

Éxito parcial

La fuente de datos se extrajo por una parte del archivo de todo el material publicado por el diario Los Angeles Times entre 1985 y 2002, lo que se traduce en alrededor de 1,1 millones de palabras en total. A ello se suman frases extraídas de la versión de 2003 de la enciclopedia multimedia Encarta, así como de la colección de artículos publicados en la enciclopedia de contenido libre Wikipedia.

Cuando se enfrentaron a los exámenes del SAT, los algoritmos pudieron rellenar con éxito los huecos en blanco en un 53 por ciento de los casos. Con los textos de Holmes, el sistema consiguió una tasa de éxito del 52 por ciento. “No es perfecto, pero mejor de lo que se puede esperar por pura casualidad”, matizan los investigadores.

Es más, el equipo fue capaz de identificar las áreas que se podrían mejorar. “Es alentador que la tercera parte de los errores se refieran a cuestiones de una sola palabra, lo que pone a prueba la definición del diccionario de una palabra”, advirtieron. Así, predicen que “con unos pocos ajustes, debe ser posible reducir esos errores”.

Sin embargo, todavía queda un 40% de los errores que parece más complicado de resolver, aquellos asociados con un cierto nivel de conocimiento general. Por ejemplo, en la frase: “Muchos temen que la [espacio en blanco] de una publicidad del tabaco más benevolente podría ser perjudicial para la salud pública”, el algoritmo se decidió por la respuesta "retirada", en lugar de la opción correcta, "ratificación".

Resolver ese problema significa que quedan aún unos cuantos años antes de que los ordenadores sean capaces de terminar con éxito total las frases de los humanos. Los investigadores seguirán trabajando para perfeccionar los dos enfoques analizados, ya que consideran que se obtienen mejores resultados que dejándolo al azar, combinando ambos métodos como una opción posible.

De momento, se conforman con dar a conocer el estudio inicial, el cual se presentará oficialmente en el 50 Congreso Anual de la Asociación de Lingüística Computacional (ACL), el fórum principal en el que se exponen las investigaciones más significativas sobre lingüística computacional y procesamiento del lenguaje natural, y que en esta ocasión se celebra en la isla de Jeju, Corea.

La fuente de datos se extrajo por una parte del archivo de todo el material publicado por el diario Los Angeles Times entre 1985 y 2002, lo que se traduce en alrededor de 1,1 millones de palabras en total. A ello se suman frases extraídas de la versión de 2003 de la enciclopedia multimedia Encarta, así como de la colección de artículos publicados en la enciclopedia de contenido libre Wikipedia.

Cuando se enfrentaron a los exámenes del SAT, los algoritmos pudieron rellenar con éxito los huecos en blanco en un 53 por ciento de los casos. Con los textos de Holmes, el sistema consiguió una tasa de éxito del 52 por ciento. “No es perfecto, pero mejor de lo que se puede esperar por pura casualidad”, matizan los investigadores.

Es más, el equipo fue capaz de identificar las áreas que se podrían mejorar. “Es alentador que la tercera parte de los errores se refieran a cuestiones de una sola palabra, lo que pone a prueba la definición del diccionario de una palabra”, advirtieron. Así, predicen que “con unos pocos ajustes, debe ser posible reducir esos errores”.

Sin embargo, todavía queda un 40% de los errores que parece más complicado de resolver, aquellos asociados con un cierto nivel de conocimiento general. Por ejemplo, en la frase: “Muchos temen que la [espacio en blanco] de una publicidad del tabaco más benevolente podría ser perjudicial para la salud pública”, el algoritmo se decidió por la respuesta "retirada", en lugar de la opción correcta, "ratificación".

Resolver ese problema significa que quedan aún unos cuantos años antes de que los ordenadores sean capaces de terminar con éxito total las frases de los humanos. Los investigadores seguirán trabajando para perfeccionar los dos enfoques analizados, ya que consideran que se obtienen mejores resultados que dejándolo al azar, combinando ambos métodos como una opción posible.

De momento, se conforman con dar a conocer el estudio inicial, el cual se presentará oficialmente en el 50 Congreso Anual de la Asociación de Lingüística Computacional (ACL), el fórum principal en el que se exponen las investigaciones más significativas sobre lingüística computacional y procesamiento del lenguaje natural, y que en esta ocasión se celebra en la isla de Jeju, Corea.

Tendencias Científicas

Tendencias Científicas

La Inteligencia Artificial habla sobre la legalización del cannabis

La Inteligencia Artificial habla sobre la legalización del cannabis CIENCIA ON LINE

CIENCIA ON LINE