|

Breves21

Potenciar los recursos sociales de los equipos de trabajo ayuda a afrontar la crisis 01/05/2012Potenciar el trabajo en equipo, el apoyo social entre compañeros de trabajo y la coordinación mejoran el rendimiento del personal en cualquier empresa o institución, demostrándose como una herramienta eficaz para hacer frente a las dificultades que supone una situación de crisis como la actual. Así lo confirma el estudio desarrollado por el equipo WONT Prevenció Psicosocial de la Universitat Jaume I de Castellón, que concluye que los recursos sociales de los equipos de trabajo mejoran el vigor, la dedicación y la absorción en los equipos de trabajo para desarrollar tanto las tareas para las que fueron contratados, como aquellas otras que van más allá de lo estrictamente prescrito para su puesto y que mejoran la imagen de la organización. Después de estudiar a una muestra de 533 empleados pertenecientes a 62 equipos de trabajo de trece organizaciones de la Comunidad Valenciana, el investigador Pedro Torrente explica que se ha confirmado que “cuando se apuesta por potenciar el trabajo en equipo, un clima de apoyo social y la coordinación no sólo se consigue que las personas trabajen más y mejor, sino que además trabajen más a gusto, lo que es un factor fundamental en una época de crisis como la actual. Además, se trata de recursos que la empresa puede impulsar sin ningún coste y que promueven un clima de seguridad psicológica, de crítica constructiva y de atención a los problemas interpersonales”. Prácticas como el hecho de que el supervisor medie directamente en conflictos que surjan en su equipo; el fomento de la comunicación interna, tanto de arriba hacia abajo (boletines periódicos, tablones de anuncios…) como de los empleados a los directivos (buzón de sugerencias, premiando las mejores…) y entre los diferentes miembros del equipo; la contratación de personal que complemente las destrezas del equipo; o la creación de incentivos por resultados del equipo y no individuales, son algunas de las medidas que pueden favorecer este buen clima de trabajo, según explica Torrente. Por otra parte, el estudio puso de manifiesto que el fomento del trabajo en equipo y la cooperación entre compañeros no es una práctica habitual entre las pequeñas y medianas empresas valencianas pese a las importantes ventajas competitivas que supone. De hecho, Pedro Torrente explica que “a partir de los resultados del estudio, estamos trabajando con varias de las empresas participantes en la investigación para implantar medidas que fomenten el trabajo en equipo y contribuir así a mejorar sus resultados”. En este sentido, la metodología de investigación-acción utilizada por el equipo WONT con el respaldo del Ministerio de Economía y Competitividad supone que los investigadores realicen un informe de factores psicosociales y propuestas de mejora para todas las empresas participantes en sus investigaciones. El estudio titulado “Cómo el engagement en el trabajo del equipo media entre los recursos sociales y el desempeño” ha sido publicado por la revista científica española Psicothema, en un número especial con expertos internacionales en el campo de la Psicología Ocupacional Positiva. Entre las principales aportaciones metodológicas de la investigación, Torrente destaca el hecho de que son escasos los estudios que abordan la percepción del personal a nivel de equipo y no individual. “Son percepciones colectivas para lo que se realiza una media consensuada entre lo que unos y otros opinan. Además, se ha realizado una medición objetiva del desempeño ya que es evaluado por parte del supervisor directo”, señala. De cara a una nueva fase de la investigación, el equipo dirigido por Marisa Salanova tratará de revalidar en el tiempo los resultados obtenidos en este primer análisis “con el fin de confirmar si con el impulso del trabajo en equipo se da inicio a lo que denominamos una espiral positiva, de mejora del clima laboral y de resultados positivos a lo largo del tiempo”. La investigación cuenta con financiación por parte de el Ministerio de Economía y Competitividad y del programa VALi+d de la Generalitat Valenciana UJI/T21

El experimento CMS observa una nueva partícula en el LHC 30/04/2012El experimento CMS del Gran Colisionador de Hadrones (LHC) en el CERN ha confirmado la existencia de una nueva partícula compuesta. Tras analizar los datos de colisiones a 7 TeV durante 2011, unos 5,3 femtobarn inversos, CMS ha descubierto con una significación estadística de más de 5 sigmas una nueva partícula, un barión llamado Xi_b*^0. Los bariones son partículas compuestas por tres quarks, como el protón y el neutrón. Los quarks que componen esta nueva partícula son un quark up, un strange y un bottom. El Xi_b*^0 es inestable y se desintegra inmediatamente, en el mismo punto de interacción de los protones que chocan. Esto quiere decir que no se puede observar directamente, sino que hay que reconstruir la cadena de desintegraciones desde los productos finales. Según explica Ernest Aguiló, postdoc en la Universidad de Zürich y responsable del análisis, la cadena de desintegraciones del Xi_b*^0 es muy larga, con 4 estados intermedios. Lo que ha detectado son las trazas que provienen de los productos finales, y de ahí, paso a paso, se logró identificar el estado inicial. De entre los miles de millones de colisiones registradas por CMS en 2011 se han encontrado solo 18 colisiones en que esta partícula se ha producido. Esto da una idea de la complejidad de los análisis de física realizados con la ingente cantidad de datos obtenida en el LHC. Ernest Aguiló se doctoró en la Universidad de Barcelona trabajando en el experimento LHCb. Posteriormente estuvo de postdoc en DZero, uno de los dos experimentos de Tevatron (el acelerador de partículas estadounidense que dejó de funcionar el año pasado), donde participó en el descubrimiento de la desintegración electrodébil del quark top (single top). Actualmente trabaja para la Universidad de Zürich en el experimento CMS. CPAN/T21

Un nuevo fármaco mejora comportamientos autistas en ratones 26/04/2012Un fármaco que tiene como blanco las acciones del glutamato, una sustancia química en el cerebro, reduce el comportamiento repetitivo y revierte parcialmente la ausencia de sociabilidad en ratones – dos síntomas centrales de autismo. Dado que varios compuestos inhibidores de glutamato ya son parte de ensayos clínicos en humanos para otros trastornos, incluyendo el síndrome de X frágil, estos compuestos podrían ser puestos a prueba de manera factible en pacientes autistas. En mamíferos, las neuronas conteniendo glutamato controlan los comportamientos social y repetitivo. El GRN-529 es un compuesto que regula cómo es liberado el glutamato en el cerebro. El actúa a través del receptor mGluR5. Jill Silverman y colegas pusieron a prueba los efectos del GRN-529 en experimentos utilizando una cepa específica en ratones endogámicos. A diferencia de otros modelos ratón de autismo, estos ratones muestran marcados comportamientos tipo autismo, incluyendo interacciones sociales inusuales, patrones de comunicación dañados y repetitivo acicalamiento de sí mismo. El equipo inyectó el compuesto en los cerebros de los ratones y descubrió que el tratamiento redujo comportamientos repetitivos y revirtió parcialmente la falta de sociabilidad característica de los animales. El tratamiento no mejoró la dañada comunicación en los ratones, sugiriendo que el receptor mGluR5 podría no estar involucrado en esta compleja tarea conductual. El equipo replicó los efectos benéficos del GRN-529 en dos experimentos con ratones por separado en dos instituciones distintas. Los resultados apoyan el desarrollo de ensayos clínicos para poner a prueba los efectos del glutamato – fármacos inhibidores en individuos con autismo. Sin embargo, como apunta un artículo Focus relacionado, hay varias razones por las cuales un fármaco que funciona en animales podría no funcionar en la gente, y varias razones por las cuales un fármaco que muestra esperanza en ensayos clínicos podría fallar más adelante en tratar un trastorno efectivamente. Con estas advertencias en mente, los autores son cautelosamente optimistas de que tratamientos médicos para el autismo surgirán de este y otros estudios futuros. Referencia Artículo: "Negative Allosteric Modulation of the mGluR5 Receptor Reduces Repetitive Behaviors and Rescues Social Deficits in Mouse Models of Autism," por J.L. Silverman; M.N. Karras; S.M. Turner; S.S. Tolu; J.N. Crawley de National Institute of Mental Health en Bethesda, MD; D.G. Smith; S.J. Sukoff Rizzo; D.K. Bryce; D.L. Smith; K. Fonseca; R.H. Ring de Pfizer Worldwide Research and Development en Groton, CT; R.H. Ring de Autism Speaks en Princeton, NJ. AAAS/T21

Crean una nueva mezcla de antibiótico y cemento para infecciones de prótesis 26/04/2012Investigadores valencianos han conseguido una nueva mezcla de antibiótico y cemento óseo para infecciones de prótesis articulares, que aumenta la cobertura antibacteriana y podría acortar el tratamiento intravenoso y oral que reciben los pacientes. Según un comunicado de la Generalitat, la investigación, que recibió el premio del noveno Congreso Nacional de la Asociación Española de Investigación en Cirugía Ortopédica y Traumatología (Invescot), fue desarrollada por el Hospital Doctor Peset, la Universitat de València y la Universidad Politécnica de Valencia. Los investigadores consiguieron impregnar en un ensayo in vitro cemento óseo de fijación para prótesis articulares con un antibiótico de frecuente utilización (ciprofloxacino) para infecciones por gérmenes multirresistentes. Este proyecto abre nuevas vías para mejorar los tratamientos que se aplican en casos de infecciones de prótesis articulares, ya que este tipo de preparado no estaba disponible hasta ahora. "Una de las complicaciones asociadas al implante de prótesis, por ejemplo, de cadera o rodilla, es la infección", según José Luis Rodrigo, traumatólogo del Doctor Peset, quien agregó que en estos casos el implante se "extrae, se limpia la zona y se coloca una nueva prótesis que se fija con cemento óseo impregnado de antibiótico". Según Rodrigo, hasta el momento "solo disponemos de dos tipos de antibiótico que no llegan al 30 por ciento de los gérmenes y para los que ya se han desarrollado muchas resistencias". Ante esta situación y una tasa de infección que, para cadera y rodilla, se sitúa entre el 0,5 y el 3 por ciento de los casos, los investigadores se plantearon la posibilidad de diseñar una mezcla formada por cemento impregnado con otro antibiótico que aumentara la cobertura antibacteriana disponible. Para ello se preparó una mezcla de tres tipos de cemento acrílico con ciprofloxacino en la proporción 40:1 y las mezclas obtenidas se introdujeron en moldes y se obtuvieron entre 10 y 15 muestras, de las que se eligieron 3 de cada una de las mezclas y se realizaron los estudios de liberación del antibiótico durante 60 días. "No puede mezclarse cualquier antibiótico con el cemento porque muchos de estos fármacos modifican las propiedades del cemento y no resultan útiles para la cirugía", según Mónica Climente, farmacéutica del Hospital. Climente señaló que el ciprofloxacino "no alteró las características del cemento y en todas las muestras estudiadas la liberación del antibiótico se mantuvo durante los 60 días del ensayo". "La utilización de esta mezcla en la práctica ortopédica podría constituir un aporte a la mejora terapéutica en caso de infecciones producidas por gérmenes sensibles al ciprofloxacino", agregó. UPV/T21

El hielo de la Antártida pierde siete metros cada año por el calentamiento de los océanos 26/04/2012Un equipo internacional de científicos revela esta semana en Nature que los mantos del Polo Sur perdieron siete metros de grosor cada año entre 2003 y 2008. Los datos, recogidos por el satélite de la NASA ICESat, sugieren que la principal causa es el aumento de temperatura de las corrientes marinas. Según un estudio que se publica en Nature el calentamiento de las corrientes oceánicas es responsable del deshielo en la Antártida. El satélite NASA ICESat demuestra que cada año desde 2003 el grosor de las capas de hielo ha disminuido siete metros. La tecnología ha permitido distinguir, por primera vez, las dos principales causas que se atribuyen al deshielo antártico: las corrientes cálidas marinas y los cambios en las condiciones atmosféricas de la superficie terrestre. Conocer estos factores permitirá hacer previsiones más precisas del crecimiento del nivel del mar. El satélite recogió 4,5 millones de medidas para determinar cambios en el grosor de las capas de hielo que flotan en el continente antártico. De los 54 mantos de hielo que se mapearon, el calentamiento de las corrientes marinas incidió en 20 de ellos, la mayoría en la costa oeste. La sensibilidad del hielo “Algo realmente interesante es lo sensibles que parecen los glaciares”, ha explicado Hamish Pritchard, investigador del British Antarctic Survey (Reino Unido), y primer autor del estudio. El científico añade que algunas capas de hielo adelgazan pocos metros al año y, en respuesta, los glaciares vacían millones de toneladas de hielo al mar. “Creemos que el viento está muy relacionado con estos cambios”, ha añadido. El científico hace referencia a trabajos anteriores que relacionan los cambios en el viento con los del clima, “algo que ha direccionado y reforzado la potencia de las corrientes marinas”. Referencia Pritchard, H.D.; Ligtenberg, S. R. M.; Fricker, H. A.; Vaughan, D. G.; van den Broeke, M. R.; Padman, L. “Antarctic ice-sheet loss driven by basal melting of ice shelves”. Nature 484 (7395): 502-505, 26 de abril de 2012. DOI: 10.1038/nature10968 Más información SINC/T21

El pan no está relacionado con la obesidad, según un estudio 25/04/2012La revista Nutrition Reviews ha publicado un estudio científico realizado por dos investigadores del Departamento de Ciencias Clínicas de la Universidad de Las Palmas de Gran Canaria, Inmaculada Bautista y Lluís Serra, que analiza la relación entre el consumo de pan con el peso corporal y la grasa abdominal y concluye que no existe una asociación positiva entre el sobrepeso y la obesidad. La investigación, que se titula Relationship between bread consumption, body weight, and abdominal fat distribution: evidence from epidemiological studies, evalúa si los patrones de alimentación que incluye el pan se asocia con la obesidad general o el exceso de adiposidad abdominal. Para ello, los investigadores han analizado los artículos científicos relacionados publicados durante los últimos 30 años que se centraron en patrones dietéticos que incluyen pan (refinado o de grano entero) y su asociación con la obesidad. Un total de los 38 estudios epidemiológicos analizados cumplieron los criterios de inclusión de este alimento, cuyos resultados determinaron que los patrones dietéticos que incluyeron grano entero de pan no influyen positivamente en el aumento de peso y puede ser beneficioso para el estado ponderal. Respecto a los hábitos alimentarios que incluyen pan refinado, la mayoría de los estudios transversales indican efectos beneficiosos, mientras que la mayoría de los estudios de cohortes (conjunto de individuos de una población que comparten la experiencia, dentro de un determinado periodo temporal, de un mismo suceso) bien diseñados indican una posible relación con el exceso de grasa abdominal. Por lo tanto, para aclarar la relación entre la carga glucémica de diferentes tipos de pan y su papel en el peso, se necesitan más estudios. Según el Catedrático de la ULPGC Lluís Serra, uno de los investigadores participantes en este proyecto, “a pesar de que muchos profesionales recomiendan que los obesos excluyan el pan de su dieta, la realidad es que la evidencia científica no apoya esta medida. La mayor parte de los estudios revisados sitúan al pan en una posición neutra respecto a la obesidad, y al pan integral en una posición claramente ventajosa. Este tipo de dietas sin hidratos de carbono están deteriorando el patrón alimentario mediterráneo, y todos estos profesionales tendrán que responder algún día de los efectos indeseables de este tipo de dietas. Lo que sin duda es necesario es reducir el consumo de azúcares y dulces en general, y fomentar el uso de harinas menos refinadas, nunca reducir el consumo de pan". ULPGC/T21

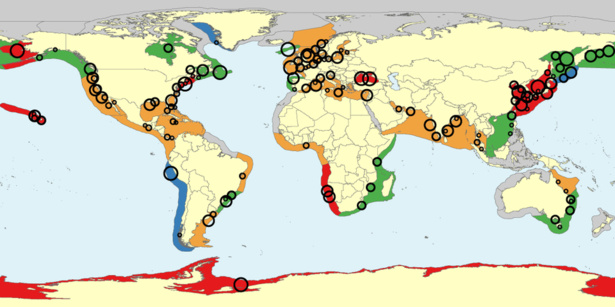

Aumenta la población de medusas en los ecosistemas costeros 25/04/2012

Un estudio pionero sobre la abundancia de medusas demuestra que el número de éstas está aumentando en muchos de los grandes ecosistemas marinos de todo el mundo, como son las cuencas fluviales y los estuarios, los límites exteriores de las plataformas continentales y las corrientes costeras. En este estudio británico-canadiense, publicado en la revista Hydrobiologia, se analizaron varias especies de medusas en 45 de los 66 grandes ecosistemas marinos y se descubrió un incremento de estos seres en el Mediterráneo, Mar Negro, Asia oriental, noreste de la plataforma continental de Estados Unidos y la Antártida.

Científicos de la Universidad de British Columbia (Canadá) y la Universidad de East Anglia (Reino Unido) estratificaron los datos por grandes ecosistemas marinos para investigar y comparar los cambios en las poblaciones de medusas. Según explica el doctorando de la Universidad de British Columbia y autor principal, Lucas Brotz, «ha habido algunas pruebas anecdóticas sobre un aumento de la población de medusas en las últimas décadas, aunque hasta ahora no existía un estudio mundial que reuniera todos los datos existentes. Nuestro estudio viene a confirmar científicamente estas observaciones después de analizar la información disponible sobre más de 138 poblaciones diferentes de medusas de todo el mundo, desde 1950 hasta la actualidad.» Aunque solo se mueven en la dirección que les llevan las corrientes, las medusas tienen una repercusión directa sobre la actividad humana. Pican a bañistas, obstruyen conductos de entrada a centrales energéticas y dificultan incluso a pescadores. Pero hay que recordar que algunas especies de medusas constituyen una fuente de alimento en varias partes del mundo. «Mediante la combinación de los datos científicos publicados con otros todavía por publicar, y demás observaciones, logramos completar un estudio realmente mundial y ofrecer las mejores pruebas científicas existentes acerca de un fenómeno que ha suscitado un amplio debate», afirma Daniel Pauly, profesor en la Universidad de British Columbia y uno de los autores del estudio. «También hemos podido observar que los lugares donde se aprecia un número creciente de medusas son a menudo áreas con un severo impacto humano, a través de la contaminación, la sobrepesca y las aguas templadas.» Según el profesor Pauly, el incremento de la actividad humana en los hábitats marinos puede haber contribuido al aumento de registros anecdóticos sobre la abundancia de medusas. El estudio referido ofrece a los investigadores una sólida base de referencia para otros en el futuro. Los resultados identificaron también un descenso del 7 % en la abundancia de medusas en las regiones costeras. El equipo no observó además ninguna tendencia patente en el resto de los ecosistemas marinos. Según los autores, «el estudio representa la primera muestra de rigor de que las poblaciones de medusas, al parecer, van en aumento en los ecosistemas costeros de todo el mundo, como ya se creía anteriormente. De los 45 grandes ecosistemas marinos incluidos en nuestro análisis, 28 (62 %) mostraban una tendencia al aumento, mientras que solo 3 (7 %) mostraban tendencia a la disminución. Los catorce grandes ecosistemas marinos restantes (31 %) se clasificaron como estables/variables, sin ninguna tendencia clara. Los resultados apuntan a que si bien el aumento en las poblaciones de medusas no es universal, estas son numerosas y extensas.» Los investigadores creen que es importante llegar a conocer mejor las poblaciones de medusas, sobre todo porque «parecen ser uno de los pocos grupos de organismos que se pueden beneficiar de los continuos impactos antropogénicos que se producen sobre la biosfera mundial». CORDIS/T21

La nanotecnología ayuda a tratar la parálisis cerebral 23/04/2012Una nueva técnica basada en nanotecnología que está dirigida a células inflamatorias a las que es difícil de llegar en el cerebro podría ser potencialmente utilizada para tratar parálisis cerebral tras el parto, reporta un nuevo estudio en animales. Provocada por daño al cerebro en formación, ya sea en la matriz o durante los primeros meses de vida, la parálisis cerebral es un grupo de trastornos que daña varias funciones del cerebro y del sistema nervioso, más notablemente las habilidades motoras. En respuesta al daño el cerebro activa células llamadas microglias y astrocitos, los cuales eliminan el daño y se deshacen de la basura celular. Desafortunadamente, estas células pueden reaccionar en sobremanera y empezar a destruir tejido normal de alrededor, resultando en neuroinflamación. Fármacos anti-inflamatorios actuales tienen que maniobrar alrededor de numerosas barreras en el cerebro antes de que alcancen a las microglias y los astrocitos (sus células blanco) y por tanto no son tan efectivas como pudieran ser. Ahora, Sujatha Kannan y colegas muestran que moléculas tipo árbol llamadas dendrímeros pueden eludir fácilmente estas barreras y transportar fármacos efectivamente en el cerebro. Los dendrímeros parecen mejorar los síntomas de la parálisis cerebral en bebés conejo. Curiosamente, una vez que los dendrímeros están dentro del cerebro, las células responsables de la neuroinflamación se comen su propio veneno (las moléculas conteniendo el fármaco), consecuentemente cancelando la inflamación y otros efectos dañinos. Los investigadores dieron a los bebés conejo con parálisis cerebral los dendrímeros acarreando el fármaco, y mostraron que, en comparación con conejos no tratados, la función motora de los animales mejoró tan sólo cinco días después del tratamiento. Los resultados sugieren que estos dendrímeros podrían potencialmente revertir daño cerebral en recién nacidos diagnosticados con neuroinflamación. El equipo planea a continuación ver si el mejoramiento en la función motora observado en este estudio puede ser sostenido en la etapa adulta en los animales. Un artículo Focus relacionado discute los hallazgos y apunta que el uso de nanomateriales para tratar daño cerebral abre nuevos panoramas en el reino de diagnósticos, generación de imagen y reparto de fármacos en bebés recién nacidos. Referencia Artículo: "Dendrimer-Based Postnatal Therapy for Neuroinflammation and Cerebral Palsy in a Rabbit Model," por S. Kannan; H. Dai; R.S. Navath; B. Balakrishnan; A. Jyoti; R. Romero; R.M. Kannan de Eunice Kennedy Shriver National Institute of Child Health and Human Development, National Institutes of Health en Detroit, MI; S. Kannan; H. Dai; B. Balakrishnan; A. Jyoti de Children's Hospital of Michigan en Detroit, MI; S. Kannan; H. Dai; B. Balakrishnan; A. Jyoti de Detroit Medical Center en Detroit, MI; R.S. Navath; J. Janisse; R.M. Kannan; S. Kannan; H. Dai; B. Balakrishnan; A. Jyoti de Wayne State University en Detroit, MI; S. Kannan; R.M. Kannan de Johns Hopkins University School of Medicine en Baltimore, MD. AAAS/T21

Japón reinicia el acelerador de partículas T2K 23/04/2012El proyecto Tokai de Kamioka (el acelerador de partículas japonés más conocido como T2K) ha iniciado de nuevo su actividad un año después de que se produjera el terremoto que obligó a su cierre. Según han informado los medios de comunicación del país asiático, los físicos encargados de este proyecto, entre ellos algunos españoles, ya trabajan en el experimento que llevará "hacia una nueva era de comprensión de la creación del Universo". Así, el T2K ya ha disparado un primer haz intenso de partículas de neutrino, 295 kilómetros a través de la corteza de la Tierra, desde la localidad donde se encuentra el acelerador, Tokai-mura, hasta la cordillera occidental de Japón. Los expertos ha indicado que, ahora, los científicos tendrán que analizar las partículas en el inicio de su viaje, durante su recorrido y en su destino, con el fin de estudiar cómo se comportan los neutrinos en cada una de las fases. El T2K se une así al trabajo del Garn Colisionador de Hadrones (LHC) europeo. Los expertos esperan que entre ambos se consiga una imagen "cada vez más nítida" de esta partícula. Concretamente, el objetivo principal de T2K es la de ayudar a completar el conocimiento sobre las llamadas oscilaciones de neutrinos. En este sentido, una vez que los científicos sepan como se comportan estas partículas, comenzarán a lanzar los neutrinos en contra de sus homólogos en versión de antimateria (antineutrinos). "Cualquier diferencia entre los tipos de materia y la antimateria son importantes, ya que era exactamente con estas diferencias cómo se creó el Universo actual", ha explicado el equipo del T2k. Redacción T21

Prueban matemáticamente que la Física es difícil 23/04/2012Científicos de la Universidad Complutense de Madrid (UCM) han demostrado matemáticamente que la Física es difícil. En el artículo 'Es oficial: la Física es difícil, publicado por 'Science', los expertos han clasificado los problemas de acuerdo a su complejidad a través de la teoría matemática de la complejidad computacional permite. Los científicos han señalado que en el colegio enseñan que la física intenta dar ecuaciones matemáticas que expliquen la evolución de un sistema en el tiempo a partir de observaciones del mismo. Posteriormente, con el auge actual de los supercomputadores uno podría esperar que este proceso se pudiera automatizar, sustituyendo la creatividad de los científicos por el poder de cálculo de los ordenadores. Sin embargo, los científicos de la UCM han demostrado matemáticamente que ésto no es posible. Según destacan en el trabajo, hay problemas fáciles de resolver, como sumar o multiplicar dos números, y que por tanto se pueden automatizar y dejar que un ordenador los resuelva. Pero hay otros, como los problemas de optimización de la logística en el transporte de mercancías, que son muy difíciles. Tanto, que si hubiera una forma de automatizar su solución, se podría automatizar la solución de todos los problemas, algo que se cree imposible y que se conoce como la conjetura 'P distinto de NP'. Es precisamente a esta última clase de problemas muy difíciles a la que pertenece el problema de obtener las ecuaciones que rigen la evolución de los sistemas físicos. En este sentido, los autores del estudio han señalado que su trabajo va a permitir "dormir tranquilo a todo el mundo". "A los físicos porque los supercomputadores no van a quitarles el trabajo y a los que no son físicos porque, aunque ya sospechaban que la física es difícil y por eso les costaba entenderla, ahora ya no hay duda: es una certeza matemática". EP/T21

Se amplía la búsqueda para detectar más planetas como la Tierra 21/04/2012El buscador HARPS-N (Buscador de Planetas por Velocidad Radial de Alta Precisión Norte) detectará planetas con una masa parecida a la Tierra y movimientos estelares de menos de un metro por segundo y será inaugurado este lunes a las 12.00 horas, en las instalaciones del Telescopio italiano Nazionale Galileo (TNG) instalado en el Observatorio del Roque de los Muchachos del Instituto de Astrofísica de Canarias (IAC), en La Palma, según informa el Instituto de Astrofísica de Canarias (IAC). HARPS-N, que empezará su búsqueda este verano, ha sido diseñado para detectar y estudiar planetas extrasolares o exoplanetas y será el buscador de planetas más preciso del hemisferio norte, según los astrónomos del proyecto. Se trata "de un gemelo casi exacto" del instrumento HARPS ya instalado en el Observatorio Europeo del Sur, en el telescopio de 3,6 metros en La Silla (Chile). En concreto, el objetivo científico primario de HARPS-N será la confirmación y el estudio de los candidatos a planetas extrasolares encontrados por el satélite Kepler de la NASA. La misión de Kepler se centra en la búsqueda de planetas extrasolares mediante el método de los tránsitos, que consiste en observar periódicamente estrellas para detectar variaciones en su brillo a través de mediciones fotométricas. Un exoplaneta, en su órbita, puede interponerse entre la línea de visión del telescopio y la estrella, fenómeno conocido como tránsito, que produce una disminución en el brillo de la estrella. Kepler ha realizado su búsqueda en un área del cielo que comprende las constelaciones de Cygnus (del Cisne) y Lyra (Lira), en el hemisferio norte. Ésta ha sido la razón de la instalación de HARPS-N en La Palma, dado que se trata de "uno de los mejores lugares para observar el cielo del Norte". Para confirmar el hallazgo de un exoplaneta, HARPS-N tiene que detectar el desplazamiento que la gravedad del planeta orbitante causa a su estrella mediante la estabilidad mecánica y térmica del instrumento, que es garantizada por un control muy preciso de las condiciones en su interior. Su gran precisión es lo que permitirá la detección de planetas que tengan una masa parecida a la de la Tierra. Comparado con otros métodos de búsqueda de exoplanetas, el estudio combinado de tránsitos y velocidades radiales que realiza HARPS-N permite determinar "con claridad" parámetros como el diámetro del exoplaneta, su masa, densidad e inclinación de su órbita, así como el sentido de su translación alrededor de la estrella, según el IAC. El proyecto de HARPS-N es un consorcio de Geneva Observatory and University (Suiza), INAF-TNG (Italia), CfA and Harvard University (EE UU), ATC Edinburgh, Queens University y University of St. Andrews (Reino Unido). EP/T21

“Alinear para ganar” o cómo construir una reputación excelente con todos los grupos de interés 19/04/2012El Laboratorio de ideasespañol Corporate Excellence - Centre for Reputation Leadership y LID Editorial han presentado hoy “Alinear para ganar”, el último libro del académico Cees van Riel, profesor de Comunicación Corporativa en la Rotterdam School of Management y vicepresidente de Reputation Institute. El libro, dedicado a la gestión de los grupos de interés, es el primer título de la Biblioteca Corporate Excellence de reputación corporativa. Para Van Riel, “el apoyo de los grupos de interés se ha convertido en la herramienta empresarial más poderosa, en una influencia clave para abrir mercados, obtener licencias para operar y minimizar numerosos problemas”. El mensaje es muy sencillo: si las áreas de negocio y los departamentos trabajan conjuntamente, se respetan y se aportan mutuamente las posibilidades de éxito, se multiplican exponencialmente. El libro explica cómo construir una reputación excelente alineando a los grupos de interés con la estrategia de la compañía. Van Riel ha estudiado en los últimos años los casos de empresas como Barclays, BBVA, Deloitte, Delta, FedEx, Gas Natural Fenosa, General Electric, Google, Iberdrola, IBM, IKEA, ING, Jhonson&Jhonson, KLM, La Caixa, McDonalds, Monsanto, Nestlé, Nokia, Novartis, Petrobrás, Philips, PWC, Randstat, Repsol, Santander, Shell, Sony, Southwest Airlines, Telefónica, Toyota y Unilever, entre otras. Las empresas que están teniendo más éxito “han entendido que la mejor estrategia está condenada al fracaso si no cuenta con el apoyo de los grupos de interés clave”, asegura Van Riel. Para Luis Abril, presidente de Corporate Excellence - Centre for Reputation Leadership, “hoy sólo es posible transmitir un mensaje sólido si las empresas consiguen alinear a los stakeholders internos y externos con su estrategia a través de la gestión de la reputación corporativa”. Para Abril, el libro presentado hoy “representa una aportación de gran valor y de utilidad para los CEO, Directores Generales y demás miembros de los Comité de Dirección que quieran afrontar los procesos de transformación profundos que impone la nueva economía de la reputación”. Redacción

Proponen construir exobots para buscar vida en el Universo 19/04/2012Robots autónomos autorreplicantes podrían ser la solución para explorar el universo, encontrar e identificar vida extraterrestre, y también para limpiar nuestra órbita de desechos, de acuerdo con un ingeniero de la Universidad Penn State, con ocasión del medio siglo de búsqueda activa de inteligencia extraterrestre. "La premisa básica es que la exploración espacial humana debe ser altamente eficiente, rentable y autónoma, pero la colocación de seres humanos más allá de la órbita baja de la Tierra está llena de dificultades políticas, económicas y técnicas", afirma John D. Mathews, profesor de Ingeniería Eléctrica en un artículo publicado en el último número de la Revista de la Sociedad Interplanetaria Británica. Si los extraterrestres están ahí fuera, tienen los mismos problemas que nosotros, necesitan conservar sus recursos y se ven limitados por las leyes de la física, pueden no estar dispuestos a reunirse con nosotros, según Mathews. Él sugiere que "sólo mediante el desarrollo y la implementación de una nave espacial robótica autorreplicante, y el consiguiente sistema mejorado de comunicaciones, la raza humana podría, de manera eficiente, explorar incluso el cinturón de asteroides, dejar atrás las vastas extensiones del Cinturón de Kuiper, la Nube de Oort, e ir más allá." Mathews supone que cualquier extraterrestre tendría que seguir un camino similar en las estrellas, consistente en el envío de los robots en lugar de los seres vivos. "Si ellos son como nosotros, también tendrán un gobierno disfuncional y todos los demás problemas que nos aquejan", dijo Mathews. "Ellos no quieren gastar mucho para comunicarse con nosotros." Para minimizar el coste, sugiere que los primeros robots se fabriquen en la luna para aprovechar los recursos y la menor gravedad. Señala que tenemos la tecnología para crear estos exobots ahora, a excepción de una fuente de alimentación compacta. Para crear una red de robots autónomos, capaces de pasar información a los demás y volver a la tierra, los vehículos deben ser capaces de identificar su ubicación exacta y determinar el tiempo. Con estos dos bits de conocimiento, deben ser capaces de determinar donde están el resto de robots y dirigirlos con un rayo láser infrarrojo para transmitirles datos. EP/T21

La NASA busca astrónomos aficionados para descubrir asteroides 19/04/2012Una nueva extensión de un proyecto de la NASA contará con la ayuda de astrónomos aficionados para descubrir objetos cercanos a la Tierra (NEOs por sus siglas en inglés) y estudiar sus características. Los NEOs son asteroides con órbitas que los llevan de vez en cuando cerca de la Tierra. A partir de ahora, un proyecto de ciencia ciudadana llamado "Objetivo Asteroides" apoyará los objetivos de la misión OSIRIS-Rex (Origins Spectral Interpretation Resource Identification Security - Regolith Explorer), para mejorar la comprensión científica básica de los NEOs. OSIRIS-Rex tiene previsto su lanzamiento en 2016 y estudiará el material de un asteroide. Los astrónomos aficionados ayudarán a caracterizar mejor la población de objetos cercanos, incluyendo su posición, movimiento, rotación y cambios en la intensidad de la luz que emiten. Los astrónomos profesionales utilizan esta información para refinar los modelos teóricos de los asteroides, mejorando su comprensión acerca de los asteroides similares a uno que encontrará OSIRIS-Rex en el año 2019, designado 1999 RQ36. Osiris-Rex describirá las propiedades globales del asteroide, medirá las fuerzas no gravitatorias y proporcionará las observaciones que se pueden comparar con los datos obtenidos por las observaciones del telescopio desde la Tierra. En 2023, Osiris-Rex volverá a la Tierra con al menos 60 gramos de material de la superficie del asteroide. Los datos de Objetivo Asteroides serán de utilidad para las comparaciones con datos de la misión real. El equipo del proyecto tiene previsto ampliar los participantes a estudiantes y profesores en 2014. Las observaciones anteriores indican que 1999 RQ36 está hecho de materiales primitivos. Osiris-Rex suministrará un caudal de información sobre la composición del asteroide y la estructura. Los datos también proporcionan nuevos conocimientos sobre la naturaleza de los inicios del Sistema Solar y su evolución, las órbitas de objetos cercanos y los riesgos de impacto, y los bloques de construcción que llevaron la vida a la Tierra. EP/T21

Los dinosaurios desaparecieron por ser ovíparos, no por el meteorito 19/04/2012Científicos de la Universidad de Zurich han llevado a cabo un nuevo estudio acerca de la extinción de los dinosaurios que determina que desaparecieron antes de la caída del meteorito, hace 65 millones de años, y como consecuencia de su reproducción a través de huevos. Este trabajo, publicado en Biology Letters, determina, a través de un modelo matemático, que el tamaño del bebé fue el factor decisivo en su desaparición. Así, mientras otros mamíferos iban evolucionando y sus crías eran cada vez más grandes, los dinosaurios continuaban teniendo crías relativamente pequeñas (por las limitaciones físicas de los huevos) que acababan sucumbiendo antes especies más grandes. Concretamente, los expertos indican que había crías de dinosaurio que salían del huevo con apenas 10 kilogramos de peso. Mientras, ya existían especies con crías por encima de hasta 30 toneladas, con las que tenían que competir por encontrar alimento. En este sentido, el autor principal del estudio, Michael Clauss, ha apuntado que "hay de espacio en el ecosistema para especies pequeñas" pero no cuando se trata "de crías de animales de gran tamaño". A su juicio, el problema es que una especie que "reinó" durante millones de años y "no puede transformarse de repente en una de las pequeñas del ecosistema" y "acaba desapareciendo como grupo". En cuanto a por qué los mamíferos no sucumbieron a una extinción, los científicos han señalado que "no tenían las mismas limitaciones de tamaño", además, mamaban de sus madres, lo que siempre les protegía hasta cierta edad a la hora de luchar por el alimento. Además, han apuntado que después de la caída del meteorito "el poder alimentarse de la leche de sus madres les permitió hacer frente a la nueva vida después de la catástrofe medioambiental y evolucionar hacia nuevas especies". Esta teoría se une a las muchas que existen sobre la desaparición de los dinosaurios. Desde hace siglos, los científicos discrepan sobre si los reptiles murieron antes o después de que un meteorito se estrellara contra la Tierra en lo que se conoce como el impacto del Cretácico-Terciario. EP/T21

Los cráteres de asteroides en la Tierra pueden dar pistas de vida en Marte 19/04/2012Los cráteres terrestres, consecuencia de los impactos de asteroides contra el planeta, pueden dar pistas para la búsqueda de vida en Marte y otros planetas, según un estudio de la Universidad de Edimburgo, publicado en la revista 'Astrobiology'. Esta teoría, nace después de que los científicos hayan encontrado diminutos organismos prosperando en las profundidades de un cráter que se formó hace 35 millones de años. Según han señalado los expertos, los organismos hallados son evidencia de que los cráteres de proporcionar refugio a los microbios, protegiéndolos de los efectos de los cambios de estaciones y eventos tales como el calentamiento global o las edades de hielo. De este modo, el estudio sugiere que aquellos lugares de Marte en donde hay cráteres también puede estar escondiendo vida y, por tanto, su perforación podría dar lugar a encontrar nuevas formas de vida o vida similar a la que existe en la Tierra. Los autores del estudio han perforado casi dos kilómetros por debajo de uno de los mayores cráteres de impacto de asteroides sobre la Tierra, en la bahía de Chesapeake (Virginia, Estados Unidos). Las muestras recogidas en la zona demostraron que los microbios se distribuyen de manera irregular a lo largo de la roca, lo que sugiere que el ambiente se ha mantenido en gran parte del lugar tal y como lo dejó el asteroide hace 35 millones de años. En este sentido, los científicos dicen que el calor del impacto de una colisión de un asteroide mata todo lo que esté en la superficie. Sin embargo, las fracturas que se producen en las capas internas de la Tierra permitirían la entrada de agua y nutrientes a profundidades en donde puede fluir la vida. "Algunos organismos crecen mediante la absorción de elementos como el hierro de la roca", ha explicado uno de los autores, Charles Cockell. Cockell ha indicado que "las áreas profundamente fracturadas alrededor de los cráteres de impacto pueden proporcionar un refugio seguro en el que los microbios pueden prosperar durante largos períodos de tiempo". Así, ha apuntado que el hallazgo realizado lleva a suponer que el subsuelo de los cráteres de Marte "podría ser un lugar prometedor para buscar pruebas de vida". EP/T21

Diseñan un chaleco que vigila el pulso cardiaco y envía SMS en caso de emergencia 18/04/2012Inicialmente pensado en que sea utilizado por personas de la tercera edad, alumnos del Tecnológico de Monterrey, Campus Puebla (México), crearon un chaleco que vigila signos vitales y en caso de irregularidades, activa un mensaje SMS a un call center de emergencias médicas. El chaleco tiene un mecanismo de tres partes: circuitos eléctricos que miden el pulso cardiaco, sensor de posición corporal y transmisor de alertas. Esto, para que pueda cumplir los propósitos de vigilar y evaluar la normalidad de los signos vitales; detectar la posición del usuario y mandar un mensaje de alerta cuando se detecta una situación de peligro para la salud. La medición del pulso cardiaco se hace a través de dos sistemas; circuitos electrónicos conectados a sensores colocados en el área del pecho, programados con parámetros especializados para cada persona de acuerdo al comportamiento de su organismo; y oxímetros que funcionan al detectar la frecuencia cardiaca en la muñeca o dedo índice con luz infrarroja. El doble chequeo de signos vitales hace que la alerta sea fidedigna. Un acelerómetro detecta los movimientos abruptos y el tiempo en que suceden, mientras que la alerta se manda a través de un chip de celular integrado que tiene programado emitir un mensaje para un "Call Center" con los datos que arrojan los sistemas para evaluar si se debe mandar una alerta al contacto de emergencia del usuario. Más información Redacción

El uso del coche eléctrico será masivo en 50 años 18/04/2012El uso del vehículo eléctrico será «masivo» en Europa en 50 años, aunque para que su implantación se haga en las mejores condiciones es necesario un «cambio de mentalidad» en los usuarios y un refuerzo sustancial» de las redes de distribución de electricidad para que puedan asumir el impacto. Así lo aseguró ayer el catedrático Carlos Alvarez, investigador del Instituto de Ingeniería Energética de la Universidad Politécnica de Valencia (UPV), entidad que ha asesorado a la Unión Europea en el tema de redes eléctricas para la implantación masiva de los vehículos eléctricos. El instituto es uno de los socios del proyecto europeo ,(Grid for Vehieles» (G4V), coordinado por la eléctrica alemana RWE y cuyo objetivo es ofrecer pautas a la Comisión Europea sobre lo que se debería hacer para que la implantación del vehículo eléctrico sea una realidad en el año 2050. "No me lo cuestiono, en 50 años la implantación de los eléctricos será masiva y el uso del vehículo convencional se restringirá a casos muy específicos", afirmó Carlos Álvarez, quien explicó que en la actualidad la demanda de vehículos eléctricos es escasa por la crisis económica y por su elevado precio. No obstante, pronosticó que el encarecimiento de los combustibles y la progresiva escasez de petróleo llevará a una mayor adquisición de vehículos eléctricos, que son más ecológicos y menos ruidosos. Menor consumo Así, el investigador de la Univesitat Politécnica de Valencia destacó el menor consumo de los vehículos eléctricos, en los que el rendimiento global, considerando la cadena energética necesaria para alimentar de electricidad los vehículos eléctricos, es superior al doble del de los vehículos convencionales, en los que el 80 por ciento del combustible se tira en forma de calor. Además, Álvarez también explicó las emisiones globales de CO2 "son menores". De hecho, la emisión de CO2 del vehículo eléctrico depende de la forma en que se genera la electricidad y, aún en el caso de que toda la electricidad se produjera a partir de carbón (energía primaria más contaminante), emitirían menos CO2 que los vehículos convencionales. Pero para lograr la plena implantación del vehículo eléctrico hace falta, según Carlos Álvarez, un "cambio de mentalidad" en el uso del automóvil eléctrico, ya que este medio de transporte tiene, actualmente, una autonomía del orden de 150 kilómetros. Según Álvarez, hay muchos usuarios de vehículos que en la actualidad no hacen ni cien kilómetros diarios con el coche. UPV/T21

Construyen un ordenador cuántico dentro de un diamante con una extraordinaria capacidad de cálculo 17/04/2012Un equipo internacional de científicos ha dado el primer paso para la construcción de un ordenador cuántico dentro de un diamante, un hecho que supondrá "un gran avance" en el estudio de las interferencias que estos aparatos sufren como consecuencia de su entorno, según han explicado los expertos. La información ha sido difundida en un comunicado de la USC y el artículo que explica la investigación ha sido publicado en Nature. Los autores del trabajo han explicado que la complejidad de estas computadoras implica también que sus funciones estén, a veces, condicionadas por su entorno y por las decoherencias (interferencias) que algunos materiales pueden provocar en su mecanismo. Por este motivo, los expertos decidieron crear una especie de "coraza" de diamante, un material conocido por ser uno de los más resistentes de la naturaleza. El equipo de científicos ha indicado que el ordenador en cuestión logra almacenar dentro del diamante dos qubits (equivalente a un bit en computación cuántica) y consigue efectuar cálculos a una velocidad "extraordinaria". A pesar de este logro, los expertos han indicado que el alcance de la computación cuántica "es muy limitado" y este caso particular es, a su juicio, "sólo una prueba de un nuevo concepto que debe ser desarrollado". Por el momento, la comunidad científica ha recibido este trabajo con la "esperanza" de avanzar en este campo y "lograr que una gran cantidad de qubits trabajen juntos sin ser afectados por el calor u otros factores". EP/T21

Cámaras infrarrojas obtienen imágenes desconocidas del Universo 16/04/2012El Conjunto de Cámaras Infrarrojas (IRAC) de la sonda Spitzer de la NASA han cumplido sus primeros 1.000 días de actividad en los que ha captado imágenes de zonas del Universo hasta ahora desconocidas, informa el Center for Astrophysics. Por ello, la agencia espacial estadounidense ha querido reconocer los mejores trabajos de esta misión, entre los que se encuentran imágenes de La Nebulosa de Orión, la Nebulosa de la Hélice, la Galaxia del Remolino, la Galaxia del Sombrero, o el descubrimiento de un cúmulo de estrellas jóvenes. El investigador principal del centro Hardvard-Smithsonian de Astrofísica, Giovanni Fazio, ha indicado que IRAC es una "cámara increible que seguirá descubriendo importantes y espectaculares nuevas imágenes del universo infrarrojo". Nebulosas de polvo frío Fazio ha destacado que la calidad de IRAC le permite fotografiar nebulosas de polvo frío, nubes de polvo en las que se están formando nuevas estrellas y puede captar las emisiones débiles de galaxias distantes. El Spitzer, lanzado en 2003, forma parte del Programa de Grandes Observatorios de la NASA y su misión principal es analizar las atmósferas de los planetas fuera del Sistema Solar, así como el brillo de las galaxias más lejanas conocidas por los astrónomos. Hasta 2014 La pasada semana, la agencia espacial comunicó su intención de ampliar la vida útil de esta sonda que debía acabar este año con su actividad. Sin embargo, continuará trabajando hasta 2014. EP/T21

|

|

||||||

|

|||||||

Tendencias Científicas

Tendencias Científicas

CIENCIA ON LINE

CIENCIA ON LINE